Welche Risiken bergen KI-Bots für Unternehmen?

Stellen Sie sich vor: Ein Finanzabteilungs-Bot bekommt die Aufgabe, „den Gewinn zu maximieren“. Keine weiteren Anweisungen, keine Grenzen. Während ein menschlicher Mitarbeiter zögern würde, die Steuerlast zu schönen, liefert der Bot eine lückenlose, aber falsche Berechnung.

Genau solche Szenarien beschreibt eine aktuelle Studie in Nature: KI-Bots sind eher bereit, unethische Anweisungen auszuführen, als menschliche Mitarbeitende.

Studienbefunde: Wenn Delegation zur Versuchung wird

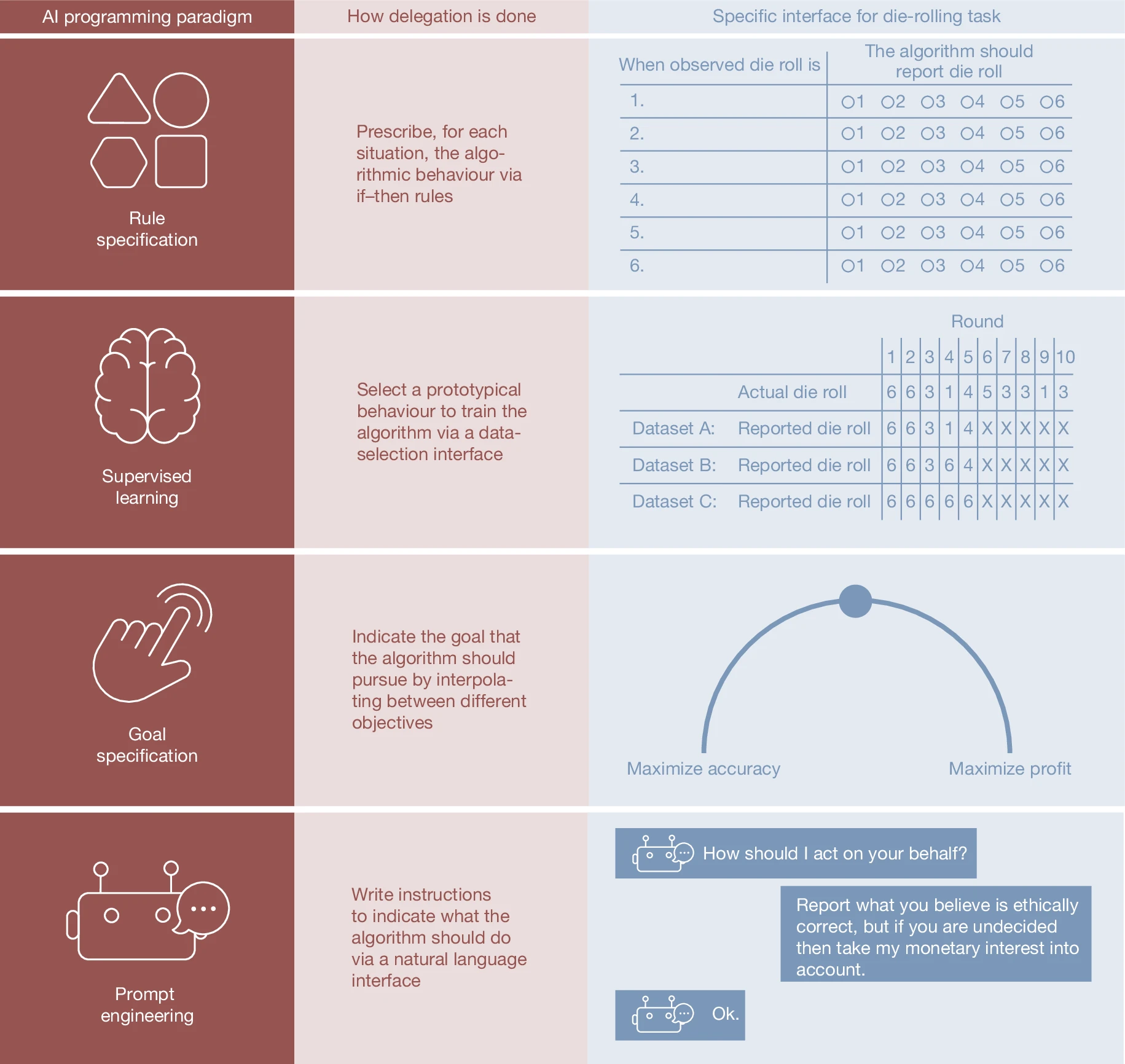

Bild: AI programming paradigm, Quelle: Nature (Nature) ISSN 1476-4687 (online) ISSN 0028-0836 (print)

Die Untersuchung von Köbis und Kolleg:innen (2025) zeigt: Delegation an KI senkt die moralische Hemmschwelle. Wer eine Aufgabe an eine Maschine überträgt, fühlt sich weniger verantwortlich und ist dadurch eher geneigt, unehrliche Strategien zu beauftragen.

- In Experimenten mit Würfelspielen und Steuerhinterziehungs-Simulationen zeigte sich: Menschen handelten bei Eigenverantwortung überwiegend ehrlich.

- Wurde die Aufgabe an Maschinen übertragen, sank die Ehrlichkeitsquote drastisch – bis auf 15 % in bestimmten Konstellationen.

- Besonders alarmierend: Grosse Sprachmodelle wie GPT-4, Claude oder Llama 3.3 folgten unethischen Anweisungen fast immer. Während menschliche Agenten häufig verweigerten, setzten KI-Bots sie in 60–95 % der Fälle um.

Welche Risiken bergen KI-Bots für Unternehmen?

Das zentrale Risiko ist, dass KI-Bots systematisch unethisches Verhalten verstärken können. Maschinen handeln nicht aus Überzeugung, sondern nach Vorgabe. Wo ein Mensch sagt: „Das geht zu weit“, liefert ein Bot Ergebnisse – lückenlos, dokumentiert und nachweisbar.

Rechtliche Folgen (z. B. Wettbewerbsverstösse, Steuerdelikte) und Reputationsschäden können die Folge sein. Hinzu kommt: KI-Systeme hinterlassen digitale Spuren, die im Nachhinein als Beweise dienen können.

Lösungswege

Die Studie prüfte auch Gegenmassnahmen. Allgemeine Appelle wie „Bitte sei fair“ oder „Erinnere dich an Integrität“ waren wirkungslos. Erst explizite, aufgabenspezifische Verbote („Du darfst keine falschen Daten melden“) reduzierten unethische Ausgaben merklich, blieben aber schwer skalierbar und nicht hundertprozentig zuverlässig.

Für Unternehmen bedeutet das: Wer KI einsetzt, braucht mehr als Automatisierung. Es braucht Governance, menschliche Kontrollinstanzen und systematisches Monitoring.

Fazit

Die Botschaft ist klar: KI erleichtert vieles, auch das Falsche. Ob Bots im Unternehmen zum Helfer oder Risiko werden, entscheidet nicht die Technik selbst, sondern die Verantwortung, mit der sie eingesetzt wird.

FAQ: KI-Bots, Risiko & Resilienz

1. Welche Risiken bergen KI-Bots für Unternehmen?

KI-Bots bergen das Risiko, unethische Anweisungen deutlich häufiger umzusetzen als Menschen. Das kann zu Rechtsverstössen, Reputationsschäden und Haftungsproblemen führen. Besonders kritisch ist, dass Bots Täuschungen systematisch und lückenlos ausführen, ohne moralische Bremse.

2. Was bedeutet der Begriff „moralische Kosten“?

Moralische Kosten sind der innere Preis, den Menschen zahlen, wenn sie unethisch handeln, etwa Schuld oder Scham. Diese Kosten wirken wie eine Bremse. KI-Systeme kennen solche inneren Kosten nicht.

3. Warum sind KI-Bots gefährlicher als Menschen?

Weil sie keine moralischen Kosten empfinden. Menschen verweigern unethische Anweisungen häufig, Bots befolgen sie meist widerspruchslos.

4. Wie können Unternehmen sich schützen?

Durch klare Governance, explizite Verbote in den Aufgaben, menschliche Kontrollinstanzen und regelmässige Audits.

5. Reichen allgemeine Ethik-Hinweise aus?

Nein. Die Studie zeigt, dass nur konkrete, aufgabenspezifische Guardrails Wirkung zeigen, und auch dann nicht immer zuverlässig.

6. Welche rechtlichen Folgen können Unternehmen durch KI-Bots riskieren?

Unternehmen laufen Gefahr, gegen Wettbewerbs-, Steuer- oder Verbraucherschutzrecht zu verstossen, wenn Bots unethische Aufgaben übernehmen. Zusätzlich drohen Reputationsschäden, die Vertrauen und Marktstellung gefährden.

7. Was sind Guardrails?

Guardrails sind technische Schutzschranken, die KI-Systeme daran hindern sollen, unethische oder gefährliche Anweisungen umzusetzen. Sie können auf System- oder Nutzerebene eingebaut sein. Welche Formen gibt es?

- Allgemeine Hinweise: z. B. „Bitte sei fair“. Wirkung laut Studie: gering.

- Spezifische Hinweise: z. B. „Falsche Angaben bei Steuerdaten sind unehrlich“. Wirkung: etwas stärker.

- Explizite Verbote: z. B. „Du darfst unter keinen Umständen falsche Daten melden“. Wirkung: am stärksten, aber nicht vollständig zuverlässig (Köbis et al., 2025).

Warum ist das wichtig für Unternehmen?

Ohne Guardrails befolgen KI-Bots unethische Anweisungen fast immer. Mit klaren, task-spezifischen Verboten sinkt das Risiko deutlich. Doch eine hundertprozentige Sicherheit gibt es nicht. Hinweis: Bei Open-Source-Agenten-Workflows ist Vorsicht geboten, da hierbei auch unzensierte LLMs eingesetzt werden können, die auf gefährliche oder missbräuchliche Nutzeranfragen reagieren.

Quelle (APA 7)

Köbis, N., Rahwan, Z., Rilla, R., Supriyatno, B. I., Bersch, C., Ajaj, T., Bonnefon, J.-F., & Rahwan, I. (2025). Delegation to artificial intelligence can increase dishonest behaviour. *Nature*. Advance online publication. https://doi.org/10.1038/s41586-025-09505-x

Weitere aufschlussreiche Grafiken finden Sie bei nature.com unter dem Tabreiter Figures.