Bias in KI: Strategien für Faire Prompts

Die folgende Präsentation erörtert die Problematik des Bias in Künstlicher Intelligenz (KI), insbesondere bei grossen Sprachmodellen wie ChatGPT, und betont, dass Verzerrungen nicht von der KI, sondern von den menschlichen Entscheidungen bei der Datenauswahl stammen.

Scheinbar perfekte Texte können subtile Verschiebungen der Realität bewirken, indem sie störende oder riskante Aspekte ausblenden.

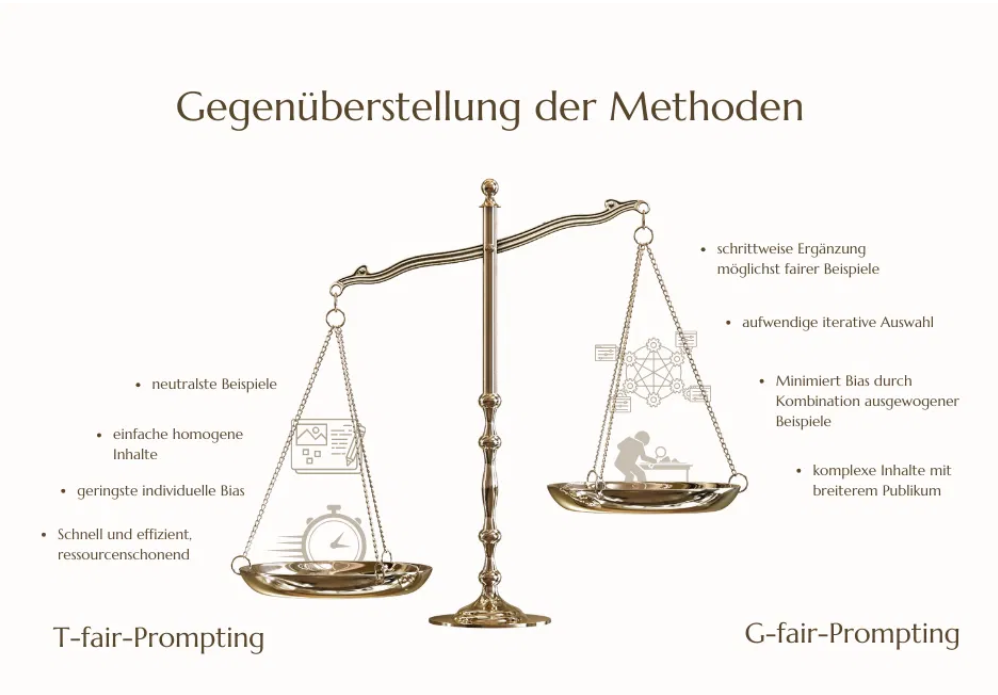

Das Bild zeigt eine Gegenüberstellung der zwei Methoden: T-Fair- vs. G-Fair-Prompting

Vorgestellt werden zwei spezifische Strategien zur Minderung dieser Verzerrungen: das T-fair-Prompting und das komplexere, aber effektivere G-fair-Prompting (Greedy-fair), welche beide darauf abzielen, die KI durch ausgewogene Beispieltexte zu trainieren.

Die Quelle schliesst mit der Feststellung, dass Fairness in der KI mehr als nur Technik erfordert; sie verlangt eine bewusste Haltung und Verantwortung der Nutzer bei der Gestaltung von Prompts.